W tym artykule, zamierzam przedstawić podstawy utrzymania jakości.

Obejmuje to zapewnienie jakości, kontrolę jakości i metrologię. Zapewnienie jakości stosujemy, aby uzyskać pewność, że wymagania jakościowe zostaną spełnione. Kontrola jakości jest używana do sprawdzenia, czy wymagania zostały spełnione. Jest to subtelna różnica i w praktyce terminy te są czasami używane zamiennie. Metrologia to nauka o pomiarach. W ten sposób zapewniamy, że możemy śmiało porównywać wyniki pomiarów dokonywanych na całym świecie.

Zasady te mogą odnosić się do produktów lub usług, ale ja zamierzam skupić się na produkcji i jak te trzy podstawowe pojęcia odnoszą się do siebie w tym kontekście. Dlatego uniknąłem szczegółów dotyczących konkretnych metod i nie zagłębiam się w żadną matematykę. Zachowam to na późniejszy artykuł.

Początki pomiarów

Egipcjanie używali standardów pomiarowych, z regularnymi kalibracjami, aby zapewnić, że kamienie będą pasować do siebie w ich wielkich projektach budowlanych. Ale nowoczesne systemy jakości tak naprawdę zaczęły się w czasie rewolucji przemysłowej. Wcześniej wyroby mechaniczne były budowane przez rzemieślników, którzy indywidualnie dopasowywali każdą część do zespołu. Oznaczało to, że każda maszyna i każda jej część była niepowtarzalna. Jeśli jakaś część wymagała wymiany to rzemieślnik musiał dopasować nową część.

Pod koniec 18 wieku, francuscy producenci broni zaczęli produkować muszkiety ze standardowymi częściami. Oznaczało to, że armia mogła nosić przy sobie części zamienne i szybko wymieniać je na zepsute. Te wymienne części nadal były dopasowywane do zespołu, ale zamiast dopasowywać każdą część do indywidualnego działa, dopasowywano je do części głównej.

Kilka lat później, amerykańscy producenci broni zaczęli używać tej metody, ale dostosowali ją do swoich niewyszkolonych pracowników. Złożyli przyrządy pomiarowe, aby dopasować je do części głównej, pracownicy ustawiali przyrządy i maszyny produkcyjne za pomocą przyrządów pomiarowych, a także używali przyrządów pomiarowych do sprawdzania części. Dzięki temu rząd maszyn, z których każda wykonywała jedną czynność przy pomocy niewykwalifikowanego operatora, mógł produkować dokładne części. Części te mogły być następnie szybko montowane w złożone maszyny.

W ten sposób położono fundamenty pod nowoczesną produkcję, ponad 100 lat przed tym, jak Ford zastosuje te pomysły w ruchomej linii produkcyjnej.

Kalibracja, wartość rzeczywista i błąd pomiaru

System części głównych, sprawdzianów i maszyn jednorazowego użytku działał, gdy cały produkt był produkowany w jednej fabryce. Nowoczesne globalne łańcuchy dostaw wymagają innego systemu.

Zamiast fizycznej części wzorcowej, mamy rysunek lub cyfrowy model CAD. Określone tolerancje zapewniają, że części będą do siebie pasować i działać zgodnie z przeznaczeniem. Zamiast każdy producent przychodzi do jednej części wzorcowej, aby ustawić swoje wskaźniki, mają swoje instrumenty pomiarowe skalibrowane. Przyrządy te są następnie używane do ustawiania maszyn produkcyjnych i sprawdzania wyprodukowanych części.

Cała jakość zależy od tego procesu kalibracji.

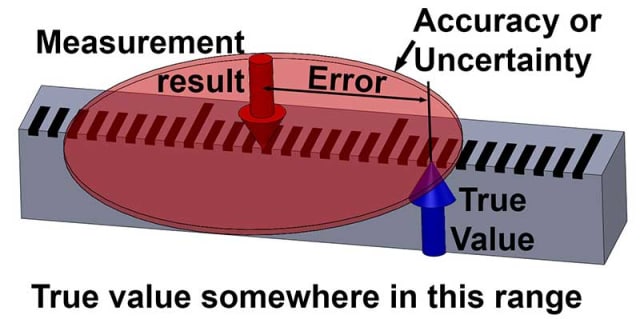

Najważniejszą koncepcją do zrozumienia jest to, że wszystkie pomiary mają niepewność. Jeśli poprosiłbym Cię o oszacowanie wysokości tego tekstu, mógłbyś powiedzieć: „to jest około 4 mm”. Użycie słowa „około” sugeruje, że istnieje pewna niepewność w twoim oszacowaniu.

W rzeczywistości nigdy nie możemy znać dokładnej prawdziwej wartości czegokolwiek, wszystkie pomiary są w rzeczywistości szacunkami i mają pewną niepewność. Różnica między wynikiem pomiaru a prawdziwą wartością to błąd pomiaru. Ponieważ nie możemy znać prawdziwej wartości, nie możemy też znać błędu: są to wielkości niepoznawalne.

Wszystko co możemy określić ilościowo o otaczającym nas świecie to wyniki pomiarów, a te zawsze mają pewną niepewność, nawet jeśli ta niepewność jest bardzo mała.

Jeśli miałeś oszacować wysokość tego tekstu jako ” około 4 mm, daj lub weź 1 mm” to teraz przypisałeś pewne granice do swojej niepewności. Ale nadal nie możesz być w 100 procentach pewny, że to prawda.

Możesz mieć pewien poziom pewności, powiedzmy 95 procent, że jest to prawda. Jeśli zwiększylibyśmy granice, powiedzmy do 2 mm, wtedy nasza pewność wzrosłaby, być może do 99 procent. Tak więc niepewność daje pewne granice, w których mamy poziom pewności, że prawdziwa wartość leży.

OK, koniec zajęć z filozofii!

W przyszłym poście, rozwinę te pomysły i jak można obliczyć niepewność dla konkretnego poziomu ufności.

Niepewność i jakość

Po określeniu niepewności (lub „dokładności”) pomiaru możemy to zastosować do decyzji czy część jest zgodna z określoną tolerancją. Na przykład, powiedzmy, że część ma mieć 100 mm +/- 1 mm. Zmierzymy ją i otrzymamy wynik 100,87 mm.

Czy część jest w specyfikacji?

Prosta odpowiedź brzmi: „Nie wiemy, może tak, ale może był błąd w naszym pomiarze i w rzeczywistości część ma więcej niż 101 mm. Może był jeszcze większy błąd i części jest w rzeczywistości mniej niż 99 mm!”

Jeśli nie wiemy, jaka jest niepewność pomiaru, nie mamy pojęcia, jak bardzo możemy być pewni, że część mieści się w specyfikacji. Załóżmy, że niepewność pomiaru została podana tak, że wynik pomiaru wynosi 100.87 mm +/- 0.1 mm przy 95 procentowej pewności. Teraz możemy powiedzieć z pewnością lepszą niż 95 procent, że część mieści się w specyfikacji.

Tak więc zrozumienie i określenie niepewności pomiarów jest krytyczne dla utrzymania jakości.

Rozważmy teraz wzorcowanie i związane z nim pojęcie identyfikowalności. Jest to podstawowy aspekt niepewności. Wzorcowanie jest porównaniem z odniesieniem, a niepewność tego porównania musi być zawsze uwzględniona, z powodów wyjaśnionych poniżej.

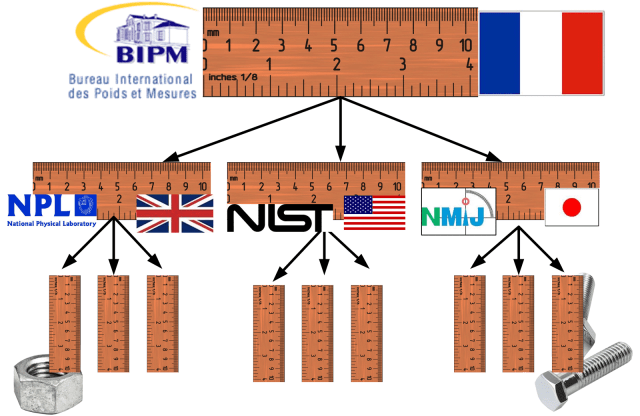

Pomiar identyfikowalny to taki, który posiada nieprzerwany łańcuch wzorcowań sięgający aż do wzorca pierwotnego. W przypadku pomiarów długości, wzorcem pierwotnym jest definicja metra; odległość przebyta przez światło w próżni w ciągu 1/299,792,458 sekundy, zgodnie z realizacją przez Międzynarodowe Biuro Miar i Wag (BIPM) w Paryżu.

Od lat trzydziestych XX wieku, cal został zdefiniowany jako 25,4 mm i dlatego jest również identyfikowalny z tym samym standardem metra. Wszystkie pomiary muszą być identyfikowalne z tym samym standardem, aby zapewnić, że części wyprodukowane w różnych krajach będą do siebie pasować.

Niepewność i błąd

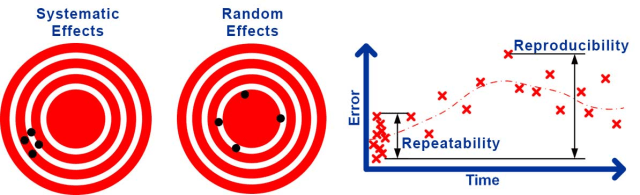

Niepewność pomiarów wynika z różnych źródeł. Niektóre z nich prowadzą do stałego błędu lub błędu systematycznego w wynikach.

Na przykład, nieznany błąd obecny podczas kalibracji przyrządu będzie prowadził do stałego błędu za każdym razem, gdy będzie on używany. Ten rodzaj efektu jest znany jako niepewność systematyczna prowadząca do błędu systematycznego. Inne źródła będą prowadzić do błędów, które zmieniają się losowo za każdym razem, gdy wykonywany jest pomiar.

Na przykład, turbulencje w powietrzu mogą powodować małe, losowo zmieniające się perturbacje w pomiarach laserowych, luzy mechaniczne i zestrojenie mogą powodować losowo zmieniające się błędy w pomiarach mechanicznych. Ten rodzaj efektu jest znany jako losowa niepewność prowadząca do losowego błędu .

Konwencjonalne jest dzielenie niepewności losowej na powtarzalność, niepewność losową wyników w tych samych warunkach i odtwarzalność, niepewność losową w zmienionych warunkach.

Oczywiście, warunki nigdy nie mogą być dokładnie takie same lub całkowicie różne, więc to rozróżnienie jest nieco niejasne. Rodzaje warunków, które mogą ulec zmianie to wykonanie pomiaru w innym czasie, z innym operatorem, innym przyrządem, przy użyciu innej kalibracji i w innym środowisku.

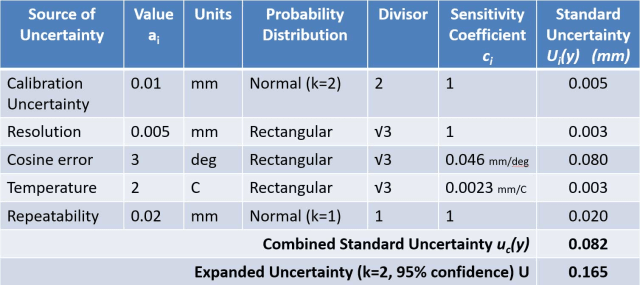

Istnieją dwie powszechnie stosowane metody ilościowego określania niepewności pomiaru. Laboratoria wzorcujące i instytucje naukowe zwykle przeprowadzają ocenę niepewności zgodnie z metodą GUM (Guide to the Expression of Uncertainty in Measurement).

Metoda GUM obejmuje najpierw rozważenie wszystkich wpływów, które mogą mieć wpływ na wynik pomiaru. Następnie należy określić model matematyczny, który przedstawia wynik pomiaru jako funkcję tych wielkości wpływających. Poprzez rozważenie niepewności każdej wielkości wejściowej i zastosowanie „prawa propagacji niepewności” można obliczyć szacunkową łączną niepewność pomiaru.

Metoda GUM jest czasami opisywana jako bottom-up, ponieważ rozpoczyna się od rozważenia każdego wpływu. Każdy wpływ jest zwykle wyszczególniony w tabeli zwanej budżetem niepewności, który jest wykorzystywany do obliczenia niepewności łącznej.

Przemysłowe procesy pomiarowe są zazwyczaj oceniane przy użyciu podejścia Analizy Systemów Pomiarowych (MSA), zgodnie z zaleceniami metodologii Six-Sigma i zazwyczaj zgodnie z wytycznymi Automotive Industry Action Group (AIAG) MSA Reference Manual .

Badanie wzorca typu 1 jest szybką kontrolą przeprowadzaną zwykle w celu wstępnego zrozumienia zmienności wzorca. Polega na tym, że jeden operator mierzy 25 lub więcej razy jedną skalibrowaną część wzorcową, a następnie rozważa zmienność i tendencyjność wyników. Ten rodzaj testu jest często nazywany badaniem powtarzalności poza MSA.

Badanie powtarzalności i odtwarzalności (Gage R&R) jest stosowane w celu uzyskania bardziej szczegółowego zrozumienia procesu pomiarowego. Zazwyczaj 10 części jest mierzonych dwukrotnie przez co najmniej trzech różnych operatorów. Następnie stosuje się technikę statystyczną zwaną ANOVA w celu określenia, w jakim stopniu zmienność jest spowodowana przez przyrząd („gage”), a w jakim przez operatora. Uznaje się, że zmiana operatora i kolejne zmiany w czasie i środowisku stanowią pełną reprezentację warunków odtwarzalności.

Zaletą oceny niepewności jest to, że jest ona w stanie rozważyć wszystkie źródła niepewności i, jeśli zostanie przeprowadzona prawidłowo, daje najdokładniejsze oszacowanie niepewności. Problemy z tym podejściem obejmują fakt, że wymaga ono metrologa zdolnego do stworzenia modelu matematycznego oraz ryzyko błędu ludzkiego prowadzącego do pominięcia lub błędnego oszacowania istotnych wpływów.

Metoda GUM jest również ważna tylko dla pojedynczego pomiaru, który został przeprowadzony z wartościami znanymi dla wszelkich zastosowanych poprawek. Dlatego trudno jest prawidłowo zastosować obliczanie niepewności do przewidywania niepewności przemysłowego procesu pomiarowego.

MSA może być znacznie łatwiejsze do zastosowania i jest przeznaczone do przewidywania dokładności przemysłowego procesu pomiarowego. Problem z tym podejściem polega na tym, że pewne efekty systematyczne są ignorowane i warunki odtwarzalności mogą nie być w pełni reprezentowane, co prowadzi do niedoszacowania niepewności.

Przykładem pominięcia efektów systematycznych jest to, że przy wyznaczaniu błędu systematycznego dokonuje się porównania z odniesieniem, które jest traktowane jako wartość prawdziwa – w rzeczywistości odniesienie ma również niepewność, która powinna być uwzględniona. Metoda ta opiera się na tym, że wszystkie warunki odtwarzalności są zróżnicowane tak, że ich skutki mogą być widoczne w zmienności wyników podczas wykonywania powtarzanych pomiarów. Jest prawdopodobne, że sposób, w jaki te warunki są zróżnicowane, nie będzie w pełni odzwierciedlał zmienności obserwowanej w czasie trwania rzeczywistego procesu pomiarowego.

Pomiar i zapewnienie jakości

Do tej pory skupiłem się na kontroli jakości, tj. jak pomiary mogą udowodnić, że części są zgodne ze specyfikacjami po ich wyprodukowaniu. Teraz, krótko rozważmy zapewnienie jakości, sposób, w jaki zapewniamy, że proces produkuje dobre części w pierwszej kolejności.

Ten aspekt jakości jest w dużej mierze adresowany przez Statystyczną Kontrolę Procesu (SPC) . Proces może być oceniany poprzez wykonanie kilku części i zmierzenie ich w celu określenia zmienności i tendencyjności w procesie produkcyjnym. Zamiast podawać te wyniki bezpośrednio, zwykle dzieli się tolerancję części przez precyzję procesu, aby otrzymać zdolność obrabiarki ( C P ) lub przez dokładność procesu, aby otrzymać zdolność procesu ( C PK ).

SPC jest pod wieloma względami równoważne MSA. Przyjmuje podejście top-down, aby zrozumieć efekty losowe i systematyczne. Jednakże, zamiast oceny pomiarów, jest używany do oceny wyników procesu. Generalnie ma takie same zalety i wady jak MSA, a podejście do oceny niepewności typu bottom-up może być zastosowane, jeżeli są one powodem do niepokoju.

Początkowo może się wydawać, że istnieją fundamentalne różnice pomiędzy MSA i SPC ze względu na bardzo różną terminologię w ramach SPC. Jednakże, zmienność spowodowana wspólną przyczyną (lub zmienność spowodowana przypadkiem w starszej literaturze) jest odpowiednikiem precyzji; zmienność krótkoterminowa jest odpowiednikiem powtarzalności; zmienność długoterminowa jest odpowiednikiem odtwarzalności; a zmienność spowodowana szczególną przyczyną (lub zmienność spowodowana przypisywalną przyczyną w starszej literaturze) jest odpowiednikiem tendencyjności.

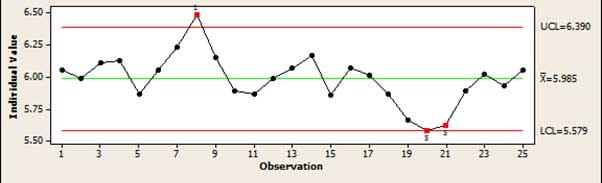

Głównym narzędziem używanym w SPC do sprawdzania procesu „w kontroli” jest wykres kontrolny. Daje to prosty graficzny obraz procesu, w którym można łatwo zauważyć, kiedy proces dryfuje lub produkuje błędy, których nie można wyjaśnić zwykłymi, losowymi zmianami. Na przykład, jeśli kilka punktów wzrasta lub maleje, oznacza to, że proces dryfuje.

W tym artykule starałem się przedstawić szeroki przegląd dużego i złożonego tematu. Przedstawiłem podstawowe zasady stojące za utrzymaniem jakości bez zagłębiania się w matematykę wymaganą do zastosowania tych metod.

Bądź na bieżąco z przyszłymi artykułami na te tematy.

Dwudziestoletnia kariera inżynierska dr Jody’ego Muelanera rozpoczęła się od projektowania maszyn, w którym pracował nad wszystkim, od urządzeń medycznych po tartaki. Od 2007 roku rozwija nową metrologię na Uniwersytecie w Bath, ściśle współpracując z wiodącymi firmami z branży lotniczej i kosmicznej. Badania te koncentrują się obecnie na modelowaniu niepewności systemów produkcyjnych, łącząc elementy SPC, MSA i metrologii z nowatorskimi metodami numerycznymi. Interesuje się również projektowaniem rowerów. Odwiedź jego stronę internetową, aby uzyskać więcej informacji.