In questo articolo, presenterò le basi del mantenimento della qualità.

Questo implica l’assicurazione della qualità, il controllo della qualità e la metrologia. Usiamo l’assicurazione della qualità per ottenere la fiducia che i requisiti di qualità saranno soddisfatti. Il controllo della qualità è usato per verificare che i requisiti siano stati soddisfatti. Questa è una sottile differenza e nella pratica i termini sono talvolta usati in modo intercambiabile. La metrologia è la scienza della misurazione. È il modo in cui ci assicuriamo di poter confrontare con fiducia i risultati delle misurazioni effettuate in tutto il mondo.

Questi principi si possono applicare a prodotti o servizi, ma mi concentrerò sulla produzione e su come questi tre concetti fondamentali si relazionano tra loro in quel contesto. Ho quindi evitato i dettagli dei metodi specifici e non mi addentro nella matematica. La conserverò per un articolo successivo.

Origini della misurazione

Gli egiziani usavano standard di misurazione, con calibrazioni regolari, per assicurare che le pietre si adattassero tra loro nei loro grandi progetti di costruzione. Ma i moderni sistemi di qualità iniziarono davvero durante la rivoluzione industriale. Prima di allora, i beni meccanici venivano costruiti da artigiani che aggiustavano ogni parte individualmente per inserirla in un assemblaggio. Questo significava che ogni macchina, e ogni parte in essa, era unica. Se una parte doveva essere sostituita, un artigiano doveva montare una nuova parte.

Alla fine del 18° secolo, i produttori di armi francesi iniziarono a produrre moschetti con parti standard. Questo significava che l’esercito poteva portare con sé pezzi di ricambio e scambiarli rapidamente con quelli rotti. Queste parti intercambiabili erano ancora lavorate per adattarsi all’assemblaggio, ma invece di adattare ogni parte al singolo fucile era adattata ad una parte principale.

Pochi anni dopo, i fabbricanti di armi americani iniziarono ad usare questo metodo, ma adattandolo ai loro operai inesperti. Hanno archiviato i calibri per adattarli al pezzo principale, gli operai hanno impostato maschere e macchine di produzione utilizzando i calibri, e anche utilizzare i calibri per controllare i pezzi. Questo permetteva a una fila di macchine, ognuna delle quali eseguiva una singola operazione con un operatore non specializzato, di produrre pezzi accurati. I pezzi potevano poi essere rapidamente assemblati in macchine complesse.

Le basi della produzione moderna erano state gettate, oltre 100 anni prima che Ford applicasse queste idee a una linea di produzione mobile.

Calibrazione, valore reale ed errore di misura

Un sistema di parti master, calibri e macchine monouso funzionava quando un intero prodotto veniva prodotto in una singola fabbrica. Le moderne catene di fornitura globali hanno bisogno di un sistema diverso.

Invece di avere una parte master fisica, abbiamo un disegno o un modello CAD digitale. Tolleranze specifiche assicurano che le parti si adattino insieme e funzionino come previsto. Invece di avere un unico pezzo master per impostare i loro calibri, ogni produttore fa calibrare i suoi strumenti di misura. Gli strumenti sono poi utilizzati per impostare le macchine di produzione e controllare i pezzi prodotti.

Tutta la qualità dipende da questo processo di calibrazione.

Il concetto più importante da capire è che tutte le misure hanno un’incertezza. Se vi chiedessi di stimare l’altezza di questo testo potreste dire: “è circa 4 mm”. Usare la parola ‘circa’ implica che c’è qualche incertezza nella tua stima.

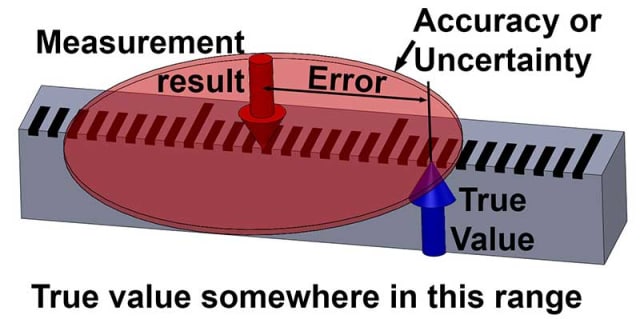

Infatti, non possiamo mai sapere il vero valore esatto di qualcosa, tutte le misurazioni sono in realtà stime, e hanno qualche incertezza. La differenza tra il risultato di una misurazione e il valore vero è l’errore di misurazione. Poiché non possiamo conoscere il valore vero, non possiamo conoscere nemmeno l’errore: queste sono quantità inconoscibili.

Tutto ciò che possiamo quantificare del mondo che ci circonda sono i risultati delle misurazioni e queste hanno sempre qualche incertezza, anche se questa incertezza è molto piccola.

Se tu dovessi stimare l’altezza di questo testo come ‘ circa 4 mm, più o meno 1 mm’ allora hai ora assegnato alcuni limiti alla tua incertezza. Ma non puoi ancora essere sicuro al 100% che sia vero.

Potresti avere un certo livello di fiducia, diciamo il 95 per cento, che sia vero. Se si dovessero aumentare i limiti, diciamo 2 mm in più o in meno, allora la fiducia aumenterebbe, forse al 99%. Quindi l’incertezza dà alcuni limiti entro i quali abbiamo un livello di fiducia che il vero valore si trova.

OK, la lezione di filosofia è finita!

In un post futuro, amplierò queste idee e come si può calcolare l’incertezza per un particolare livello di fiducia.

Incertezza e qualità

Una volta determinata l’incertezza (o “accuratezza”) di una misura, possiamo applicarla per decidere se un pezzo è conforme a una tolleranza specifica. Per esempio, diciamo che un pezzo è specificato per essere 100 mm +/- 1 mm. Lo misuriamo e otteniamo un risultato di 100,87 mm.

Il pezzo è in specifica?

La risposta semplice è: “Non lo sappiamo, forse lo è, ma forse c’è stato un errore nella nostra misurazione e in realtà il pezzo è più di 101 mm. Forse c’è stato un errore ancora più grande e la parte è in realtà meno di 99 mm!”

Se non sappiamo qual è l’incertezza della misura, non abbiamo idea di quanto possiamo essere sicuri che la parte sia entro le specifiche. Supponiamo che l’incertezza della misura sia stata data in modo che il risultato della misura sia 100,87 mm +/- 0,1 mm al 95% di confidenza. Ora possiamo dire con più del 95 per cento di confidenza che il pezzo rientra nelle specifiche.

Quindi capire e quantificare l’incertezza delle misure è fondamentale per mantenere la qualità.

Ora, consideriamo la calibrazione e il concetto associato di tracciabilità. Questo è un aspetto fondamentale dell’incertezza. Una calibrazione è un confronto con un riferimento, e l’incertezza di questo confronto deve sempre essere inclusa, per motivi spiegati di seguito.

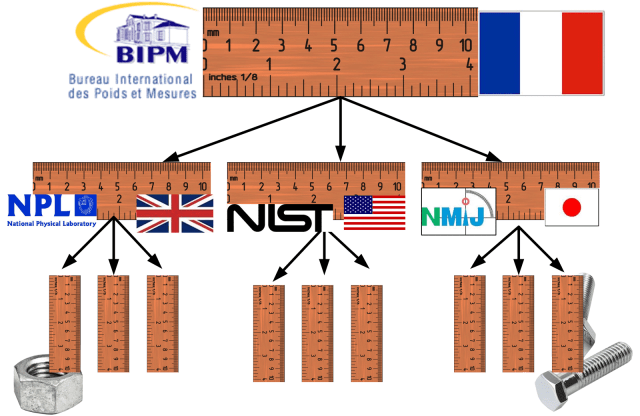

Una misura tracciabile è una misura che ha una catena ininterrotta di calibrazioni che risale fino allo standard primario. Nel caso delle misure di lunghezza, lo standard primario è la definizione del metro; la distanza percorsa dalla luce nel vuoto in 1/299.792.458 secondi, come realizzato dall’Ufficio Internazionale dei Pesi e delle Misure (BIPM) di Parigi.

Dagli anni ’30, il pollice è stato definito come 25,4 mm ed è quindi anche tracciabile allo stesso standard del metro. Tutte le misure devono essere riconducibili allo stesso standard per garantire che i pezzi fabbricati in paesi diversi si adattino tra loro.

Incertezza ed errore

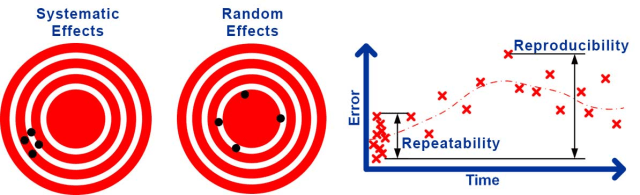

L’incertezza delle misure deriva da diverse fonti. Alcune di queste porteranno ad un errore consistente, o bias, nel risultato.

Per esempio, l’errore sconosciuto presente quando uno strumento è stato calibrato porterà ad un errore costante ogni volta che viene utilizzato. Questo tipo di effetto è noto come incertezza sistematica che porta a un errore sistematico. Altre fonti porteranno a errori che cambiano in modo casuale ogni volta che viene effettuata una misurazione.

Per esempio, la turbolenza nell’aria può causare piccole perturbazioni che cambiano in modo casuale delle misure laser, il gioco meccanico e l’allineamento possono causare un errore che cambia in modo casuale nelle misure meccaniche. Questo tipo di effetto è noto come un’incertezza casuale che porta ad un errore casuale .

È convenzionale dividere l’incertezza casuale in ripetibilità, l’incertezza casuale dei risultati nelle stesse condizioni, e riproducibilità, l’incertezza casuale in condizioni modificate.

Naturalmente, le condizioni non possono mai essere esattamente le stesse o completamente diverse, quindi la distinzione è un po’ vaga. I tipi di condizioni che potrebbero essere cambiate sono fare la misura in un momento diverso, con un operatore diverso, uno strumento diverso, usando una taratura diversa e in un ambiente diverso.

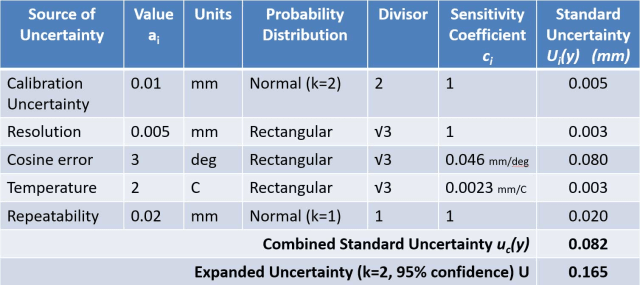

Ci sono due metodi ampiamente usati per quantificare l’incertezza di una misurazione. I laboratori di taratura e le istituzioni scientifiche normalmente eseguono la valutazione dell’incertezza secondo la Guida all’espressione dell’incertezza di misura (GUM) .

Il metodo GUM comporta innanzitutto la considerazione di tutte le influenze che potrebbero influenzare il risultato della misurazione. Si deve poi determinare un modello matematico che dia il risultato della misurazione in funzione di queste grandezze d’influenza. Considerando l’incertezza di ogni grandezza di ingresso e applicando la “legge di propagazione dell’incertezza”, si può calcolare una stima dell’incertezza combinata della misurazione.

L’approccio GUM è talvolta descritto come bottom-up, poiché inizia con la considerazione di ogni singola influenza. Ogni influenza è normalmente elencata in una tabella chiamata budget di incertezza che viene utilizzato per calcolare l’incertezza combinata.

I processi di misura industriali sono tipicamente valutati usando un approccio di Analisi dei Sistemi di Misura (MSA), come raccomandato all’interno della metodologia Six-Sigma, e solitamente seguendo le linee guida dell’Automotive Industry Action Group (AIAG) MSA Reference Manual.

L’MSA comporta l’esecuzione di Gage Studies in cui le misurazioni ripetute vengono confrontate con un riferimento in condizioni diverse per determinare la distorsione, la ripetibilità e talvolta la riproducibilità.

Uno studio Gage di tipo 1 è il controllo rapido normalmente eseguito per capire inizialmente la variazione di un calibro. Coinvolge un singolo operatore che misura un singolo pezzo di riferimento calibrato 25 o più volte e poi considera la variazione e la distorsione nei risultati. Questo tipo di test è spesso chiamato studio di ripetibilità al di fuori di MSA.

Uno studio di ripetibilità e riproducibilità dei calibri (Gage R&R) è usato per ottenere una comprensione più dettagliata di un processo di misurazione. Di solito 10 pezzi vengono misurati due volte ciascuno da almeno tre operatori diversi. Una tecnica statistica chiamata ANOVA viene poi usata per determinare quanta variazione è causata dallo strumento (‘gage’) e quanta è causata dall’operatore. Questo considera il cambio di operatore e i successivi cambiamenti di tempo e ambiente come una rappresentazione completa delle condizioni di riproducibilità.

La MSA viene talvolta definita top-down poiché tratta ampiamente il processo di misurazione come una scatola nera e determina sperimentalmente le incertezze sistematiche e casuali. Due concetti importanti nella MSA sono l’accuratezza, usata come equivalente dell’incertezza, e la precisione, usata come equivalente dell’incertezza casuale.

Il vantaggio della valutazione dell’incertezza è che è in grado di considerare tutte le fonti di incertezza e, se fatta correttamente, fornisce la stima più accurata dell’incertezza. I problemi con questo approccio includono il fatto che richiede un metrologo in grado di produrre il modello matematico e il rischio di errore umano che porta a omettere o stimare in modo errato influenze significative.

Il metodo GUM è anche valido solo per una misura individuale che è stata effettuata con valori noti per qualsiasi correzione applicata. È quindi difficile applicare correttamente la valutazione dell’incertezza per prevedere l’incertezza di un processo di misurazione industriale.

La MSA può essere applicata molto più facilmente ed è destinata a fornire una previsione per la precisione di un processo di misurazione industriale. Il problema con questo approccio è che alcuni effetti sistematici sono ignorati e le condizioni di riproducibilità possono non essere completamente rappresentate, portando a una sottostima dell’incertezza.

Un esempio dell’omissione degli effetti sistematici è che quando si determina il bias, viene fatto un confronto con un riferimento che viene trattato come il valore vero – in realtà il riferimento ha anche un’incertezza, che dovrebbe essere inclusa. Questo metodo si basa sul fatto che tutte le condizioni di riproducibilità siano variate in modo che i loro effetti possano essere visti nella variazione dei risultati quando si fanno misure ripetute. È probabile che il modo in cui queste condizioni sono variate non rifletta completamente la variazione vista durante la vita del processo di misurazione effettivo.

Misurazione e garanzia di qualità

Finora mi sono concentrato sul controllo di qualità, cioè su come le misurazioni possono provare che i pezzi sono conformi alle specifiche dopo che sono stati prodotti. Ora, consideriamo brevemente l’assicurazione della qualità, il modo in cui ci assicuriamo che il processo produca pezzi buoni in primo luogo.

Questo aspetto della qualità è ampiamente affrontato dal controllo statistico di processo (SPC). Un processo può essere valutato facendo diversi pezzi e misurandoli per determinare la variazione e la distorsione nel processo di fabbricazione. Piuttosto che dare questi risultati direttamente, è normale dividere la tolleranza del pezzo per la precisione del processo per dare la Capacità della macchina utensile ( C P ) o per la precisione del processo per dare la Capacità del processo ( C PK ).

SPC è per molti versi equivalente a MSA. Prende un approccio top-down per capire gli effetti casuali e sistematici. Tuttavia, invece di valutare le misure, è usato per valutare gli output del processo. Ha generalmente gli stessi vantaggi e svantaggi di MSA, e un approccio di valutazione dell’incertezza bottom-up può essere usato se questi sono una preoccupazione.

Può sembrare inizialmente che ci siano differenze fondamentali tra MSA e SPC a causa della terminologia molto diversa all’interno dell’SPC. Tuttavia, la variazione di causa comune (o variazione di causa casuale nella vecchia letteratura) è l’equivalente della precisione; la variabilità a breve termine è l’equivalente della ripetibilità; la variabilità a lungo termine è l’equivalente della riproducibilità; e la variazione di causa speciale (o variazione di causa assegnabile nella vecchia letteratura) è l’equivalente del bias.

SPC pone anche un’enfasi molto maggiore sulla garanzia che un processo sia in ‘controllo statistico’. In termini generali, questo significa che gli effetti sono casuali e normalmente distribuiti con qualsiasi effetto sistematico significativo corretto. Questo è un punto di forza dell’SPC ed è talvolta trascurato sia nella valutazione dell’incertezza che nell’MSA.

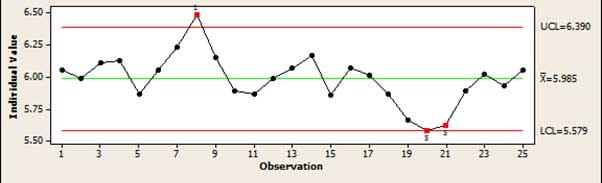

Lo strumento principale usato in SPC per verificare un processo ‘in controllo’ è la tabella di controllo. Questo dà una semplice visione grafica di un processo dove può essere facilmente individuato quando un processo sta andando alla deriva o produce errori che non possono essere spiegati da normali variazioni casuali. Per esempio, se diversi punti sono tutti in aumento o in diminuzione, questo indicherebbe che il processo sta andando alla deriva.

In questo articolo, ho cercato di dare un’ampia panoramica di un argomento vasto e complesso. Ho introdotto i principi fondamentali del mantenimento della qualità senza entrare nella matematica necessaria per applicare questi metodi.

Restate sintonizzati per futuri articoli su questi argomenti.

La carriera ventennale di ingegnere del dottor Jody Muelaner è iniziata nella progettazione di macchine, lavorando su tutto, dai dispositivi medici alle segherie. Dal 2007 ha sviluppato una nuova metrologia all’Università di Bath, lavorando a stretto contatto con le principali aziende aerospaziali. Questa ricerca si concentra attualmente sulla modellazione dell’incertezza dei sistemi di produzione, riunendo elementi di SPC, MSA e metrologia con nuovi metodi numerici. Ha anche un interesse per il design delle biciclette. Visitate il suo sito web per maggiori informazioni.